最近 University of Washington の講義を取っているのですが、何人かと雑談した際に話題にしたら「それ良いですね」「どうやって受けるのか教えてください」等々の話があったので、こちらもせっかくなのでまとめてみたいと思います。保証はしかねますが以前にあるコースを受講している際に日本やフィリピン(うろ覚え)からも参加している方がいたのも記憶しているので、今回のポストで興味があれば自分で受講することはできると思います。さすがに保証はしかねるので不安な場合は University of Washington 直に確認ください。

あんたが受講してるのは何なの?

私が受けているのは以下の CERTIFICATE IN CYBERSECURITY というコースです。日本人的に CERTIFICATE はあんまり聞きなれない方も多いと思いますが(私が最初分からんかったので他の人もそうだろうと想定)、いわゆる修士号や博士号の様な学位をとるコースをは違っており、単に「このコース受講してちゃんと課題も一通り水準以上にこなせましたよ」という様なものです。

www.pce.uw.edu

CERTIFICATE にした理由について、私の場合は「CERTIFICATE か修士か博士かなんて分かった人じゃないと踏み込んでこないし、日本国外の大学で専門知識の受講実績を持っていると箔がつく」と思ったのが主な動機です(中身が分かる方には普通に実態としての技術的な話をすればいいので)。CERTIFICATE は1年未満で修了可能なことに加え、身近にアメリカ側の修士に通っている日本人の知り合いがいますが課題量が半端じゃないので業務と並行は難しいと思って断念しました。

色々と専門分野をどれにしようかと迷いましたが、セキュリティはなんだかんだで需要は尽きないし、コンプライアンスと実務の折り合いをつけながら話せる人材は中々見かけないので、深堀分野としては悪くないかなと思った次第です。

日本からでも受けられるの?&お高いんじゃないの?

こちらのコース、アメリカ時間で夕方の午後6時~午後9時に実施されるので、日本時間としては金曜の午前11時~午後2時となります(時期によってサマータイムでやや変わるはずですが、1時間程度の差なので目安として)。平日の午前中なので調整が難しい方もいるかと思いますが、時間的には不可能な参加時間ではありません。

最新情報はリンク先を確認して欲しいですが、2023年12月23日現在での価格は8カ月コースで $4,197 となり、約60万円弱となります。国立大学の年間授業料が50万円を超えるくらいなので、安いと言える金額ではないですが物価差等々を考えるとそこまで高い値段でもないと思います。

www.chibakogyo-bank.co.jp

また、CERTIFICATE のコースは以下を見てもらえればと思いますが様々なコースがあります。こちらからコースを選択して apply すれば受講申請は可能です。

www.pce.uw.edu

技術分野でいうなら以下のコースが $3,786 とやや安めです。

www.pce.uw.edu

英語は大丈夫なの?

私自身は普段ソリューションアーキテクトとしてアメリカ側で業務しており英語でのコミュニケーション頻度が高いので、講義をちゃんと理解する&グループディスカッション等でもそこまでは困っていません。ただ、渡米当初 or 渡米直後だとかなりの負荷になったであろうことは想像に難くない程度には英語を使います。私の受講しているコースでは英語が SCORES FOR CREDIT PROGRAMS REQUIRING INTERMEDIATE ENGLISH SKILLS レベルの水準を要求されており、以下で確認すると TOEFL iBT で 92点 が目安となります。

www.pce.uw.edu

こういう換算がどこまで当てになるかは分かりませんが、TOEIC 換算だと以下によると 820 点程度らしいです。目安としてはこの程度となりますが、特に審査があるわけではないので「俺は前のめりに英語を学んでやるぜ」という人間にはお勧めです。

www.conversation.jp

実際に受けてみてどう?

セキュリティ関連について、私自身が過去に実プロジェクトで閉域網やら WAF やら PCI-DSS やら FICS やらと雑多なプロジェクトに多々放り込まれてきたので、純技術的に新しいトピックが多いかと言われると決して多くはないです。とは言っても Security Development Lifecycle や Thread Modeling 等は SI 現場だとあまり話題にならないので、その点では勉強になっています。

グループワークに限らず講師の方が話題にする内容は当然ながら「アメリカでの常識」となるので「公共案件と言ったら軍隊(日本だったら官公庁を指すことが多い)」や「なんでアメリカには GDPR みたいな統一ルールがないのか(州ごとの権限が強すぎて統一ルールが作りにくい)」等の日本に住んでるとあんまり話題にならないことが話題になるのが参考になったりします。

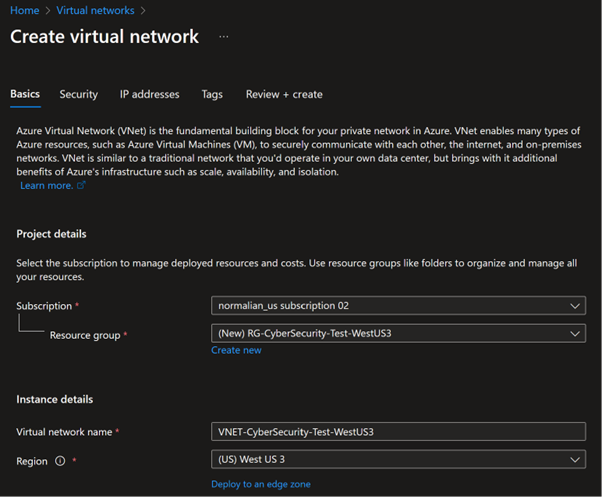

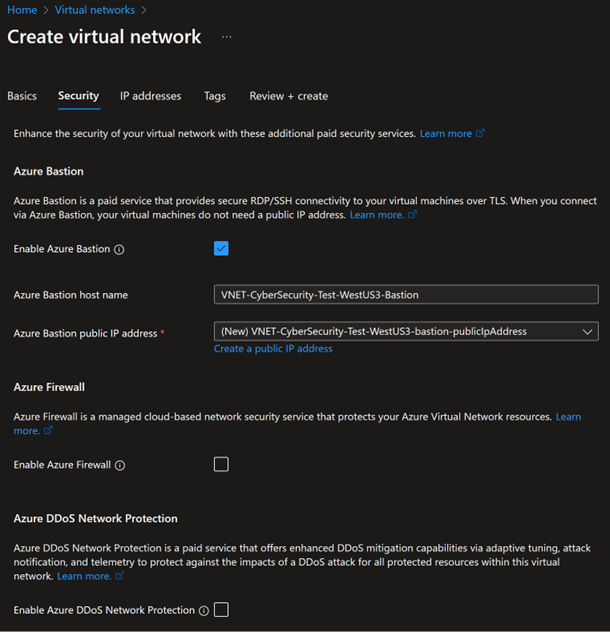

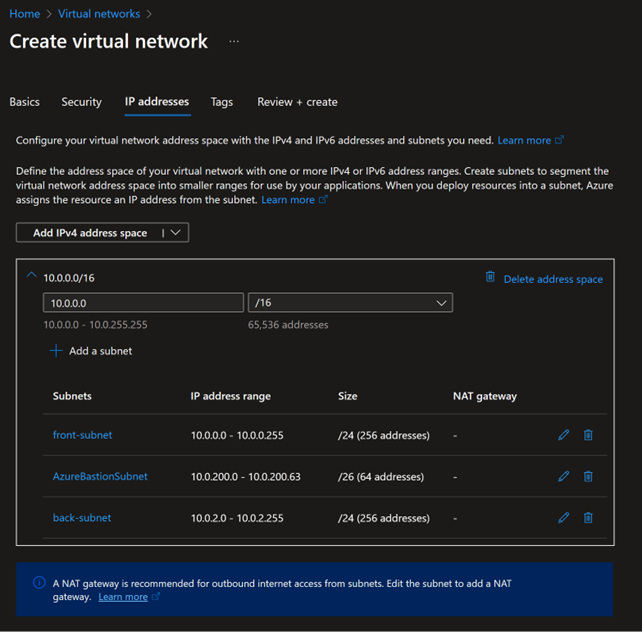

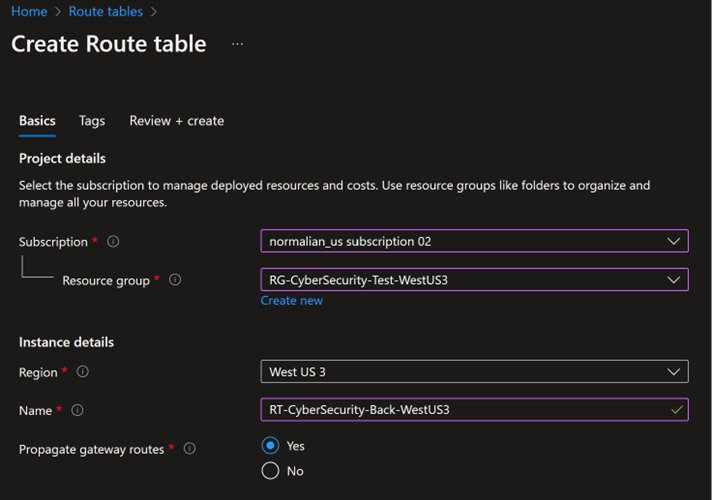

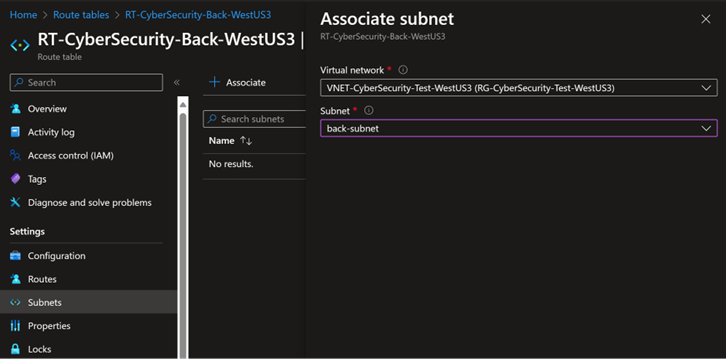

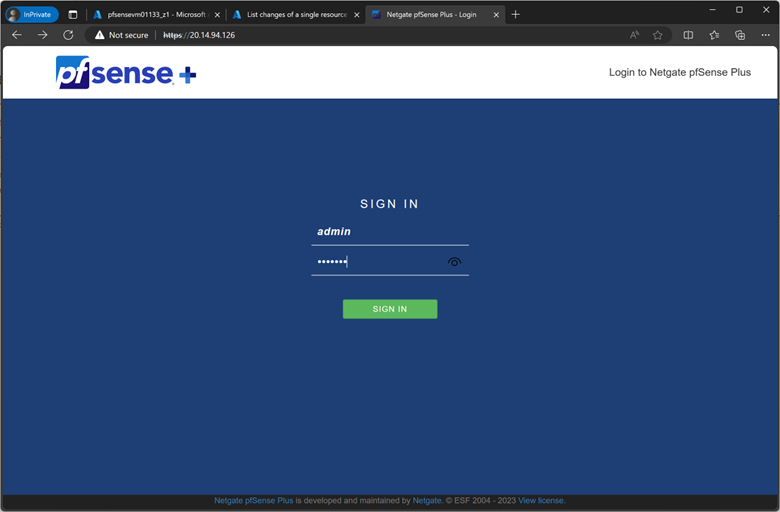

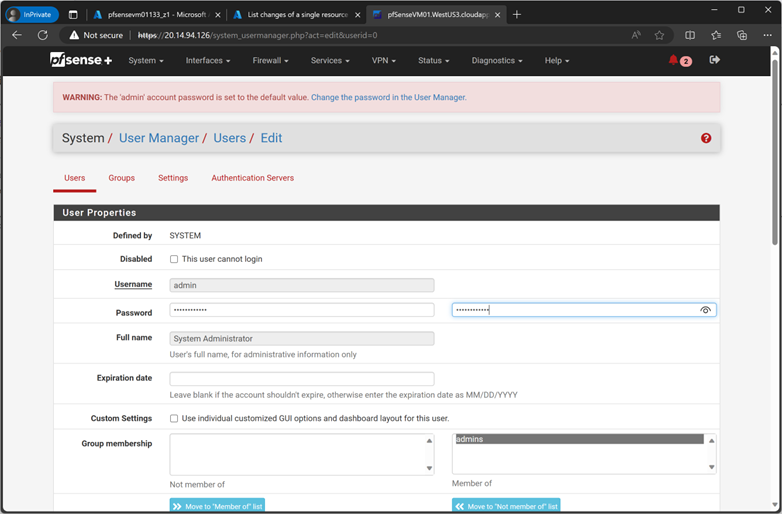

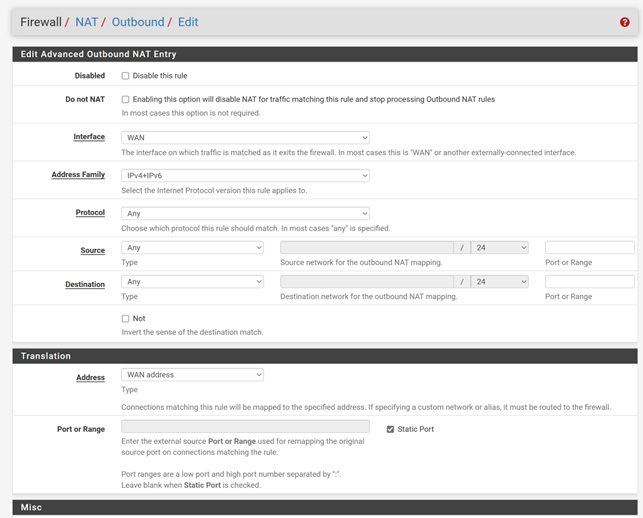

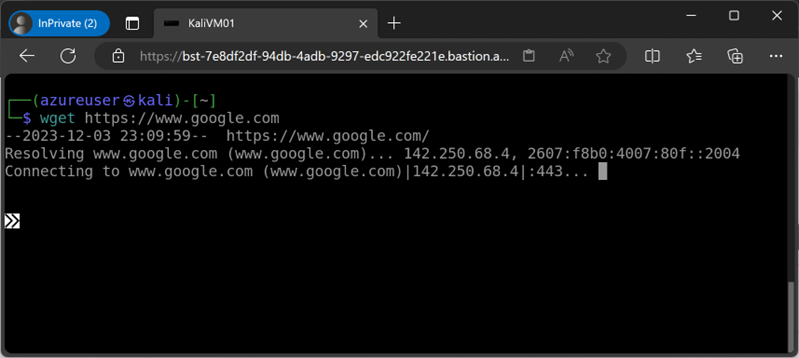

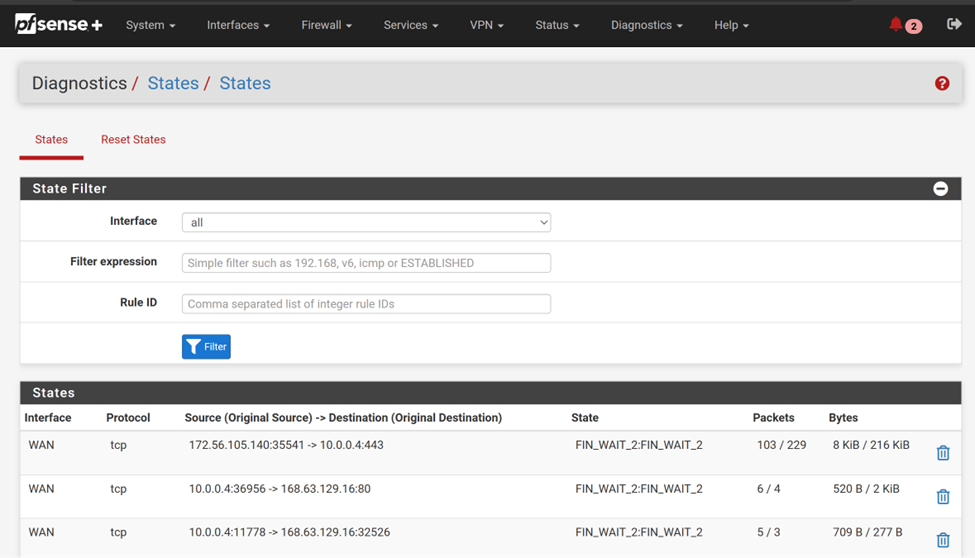

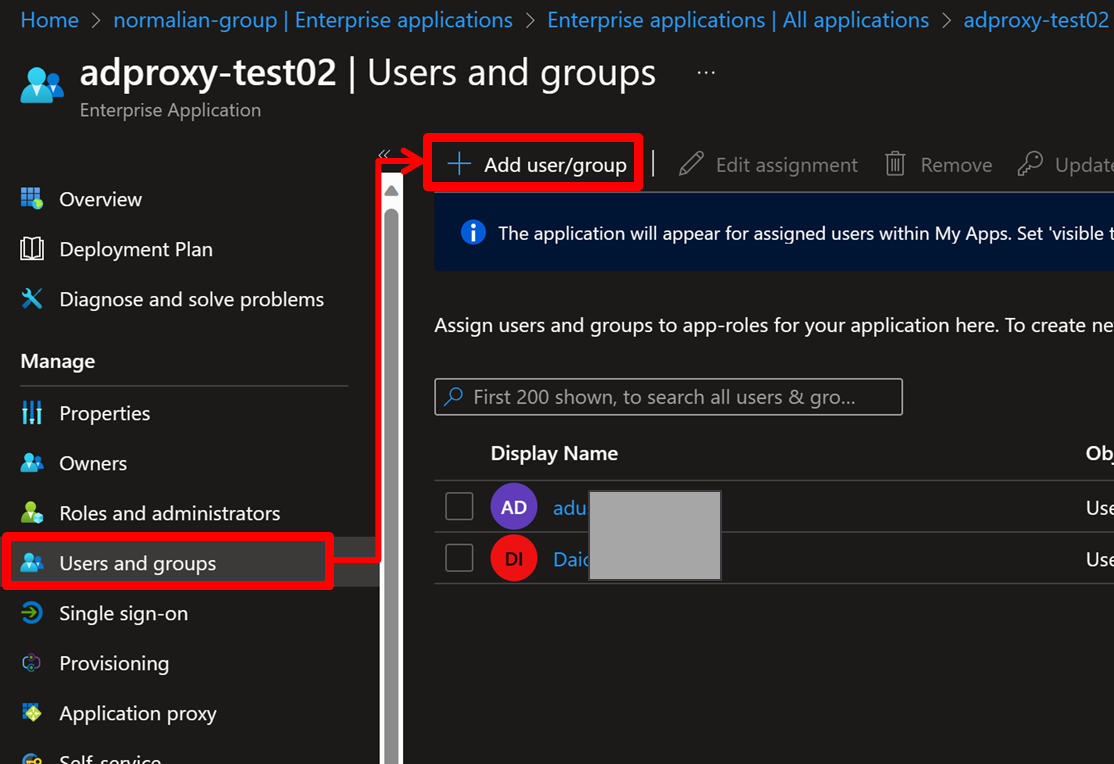

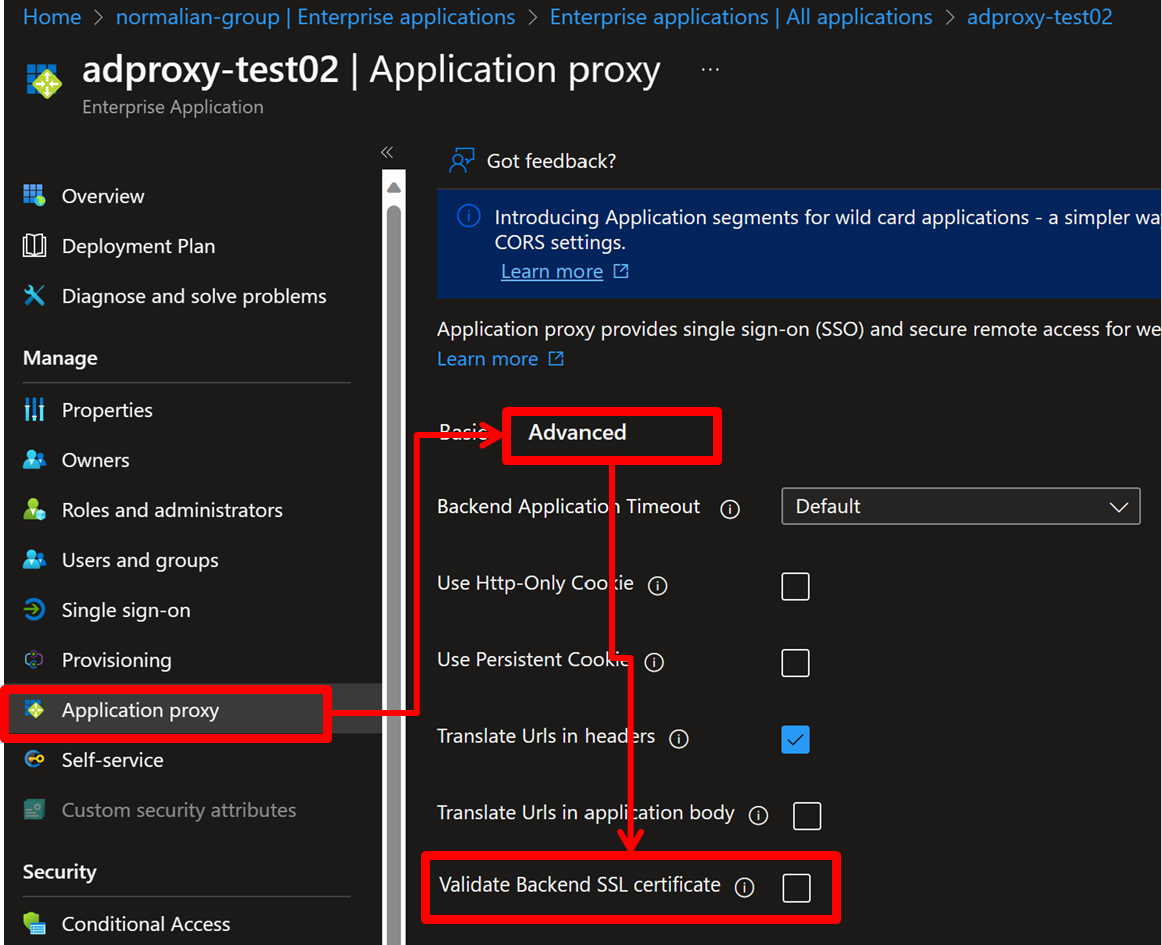

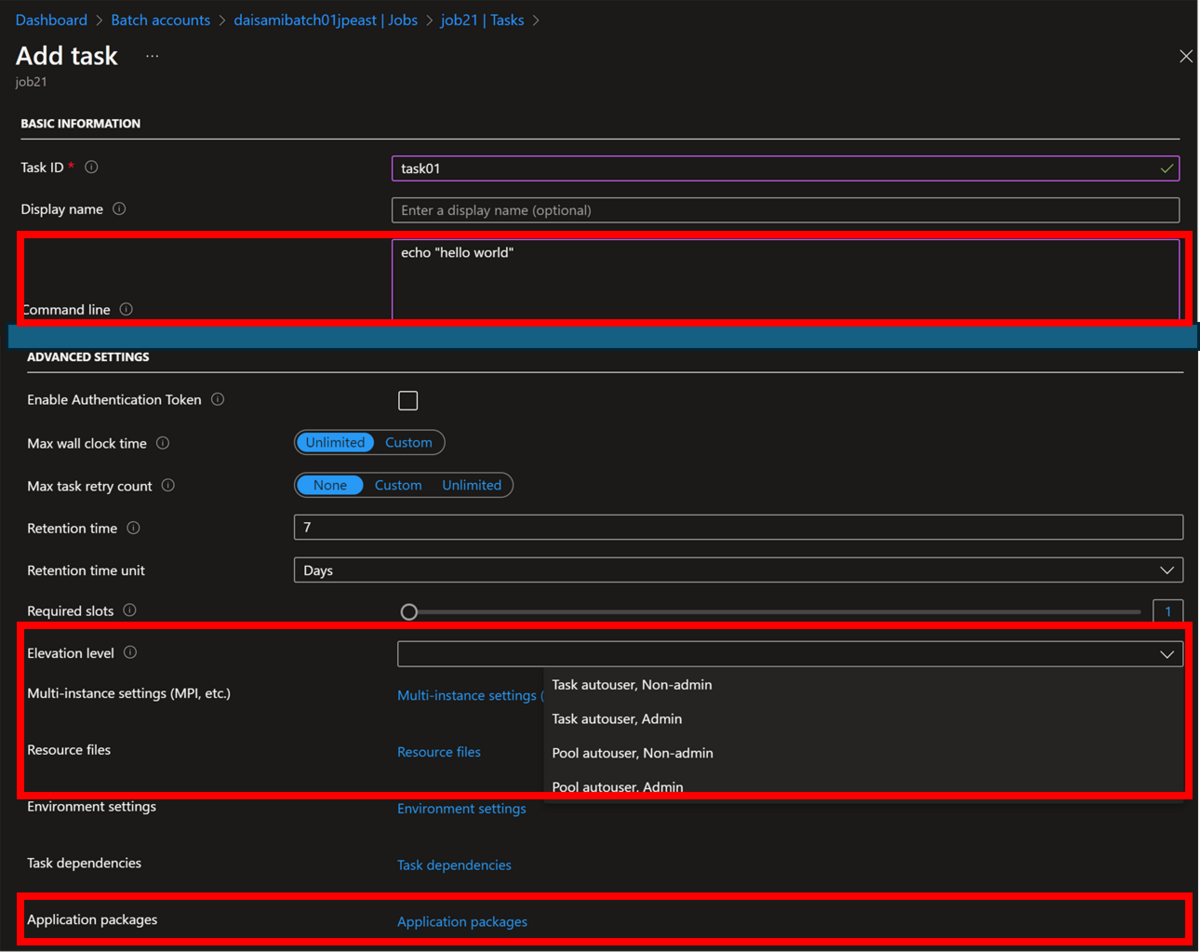

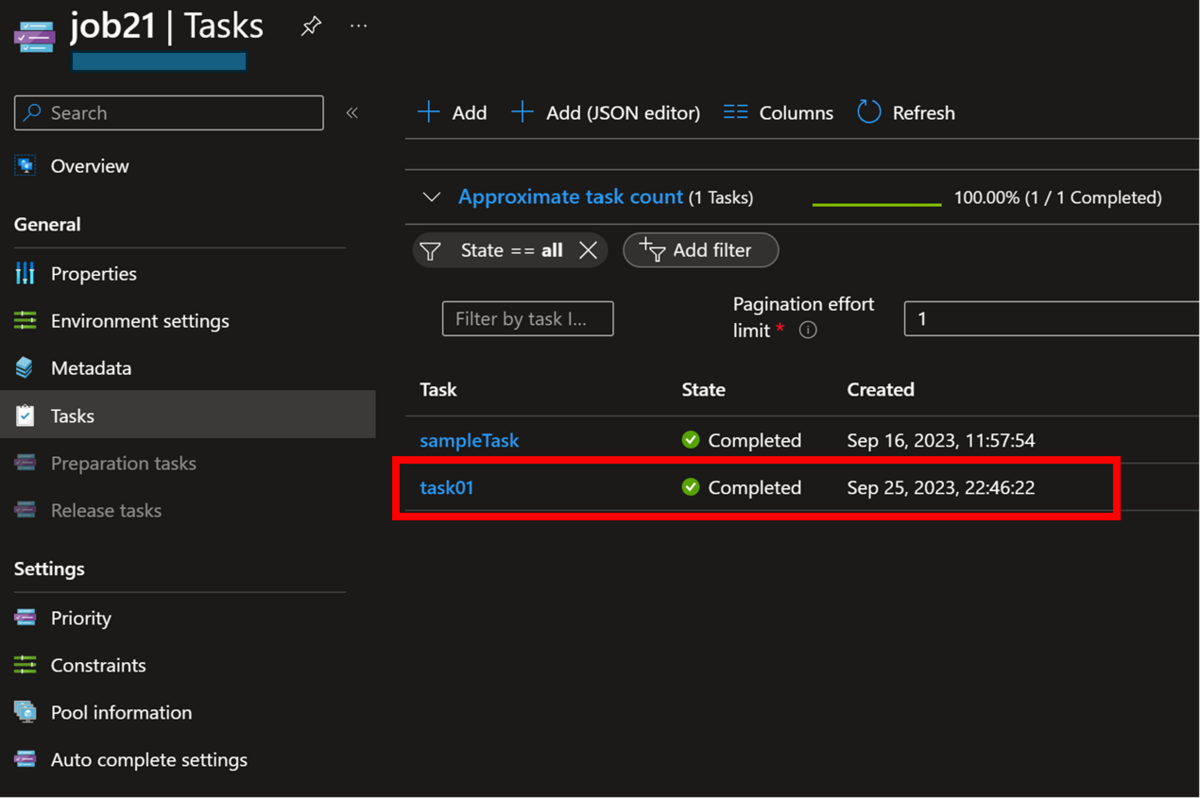

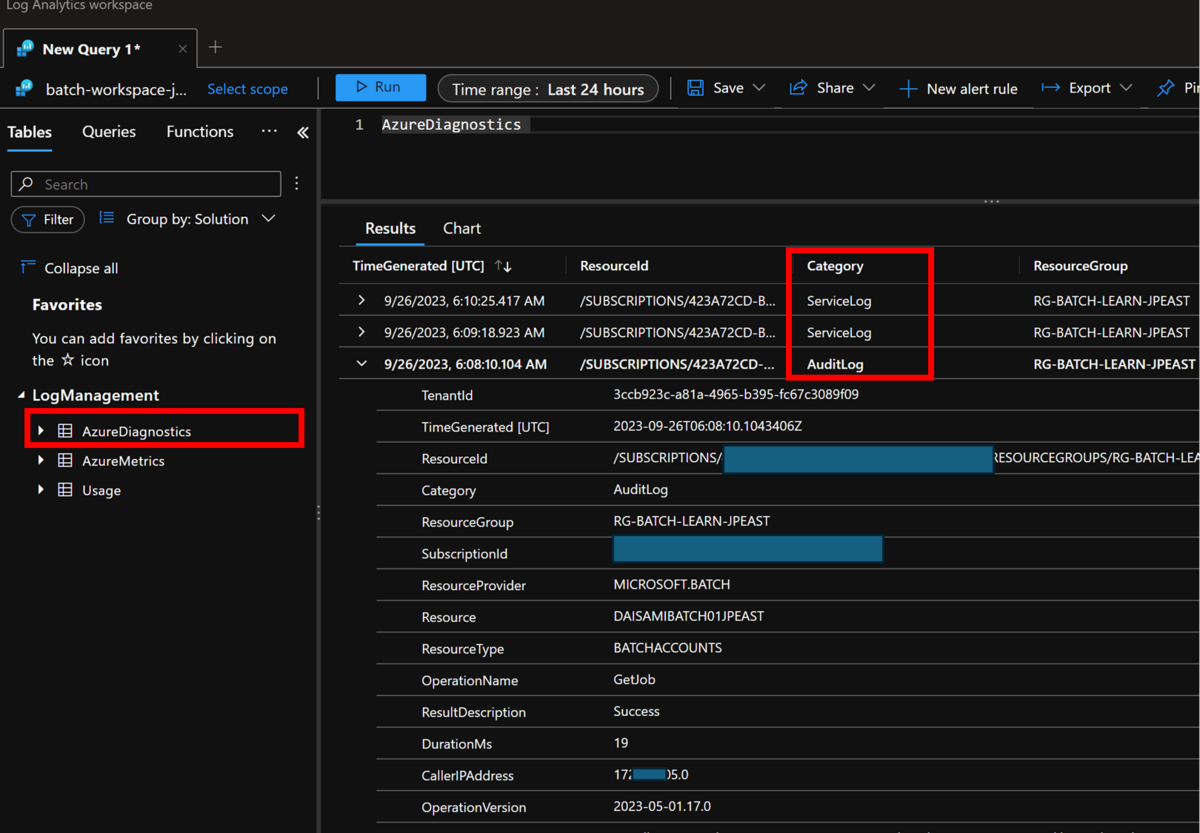

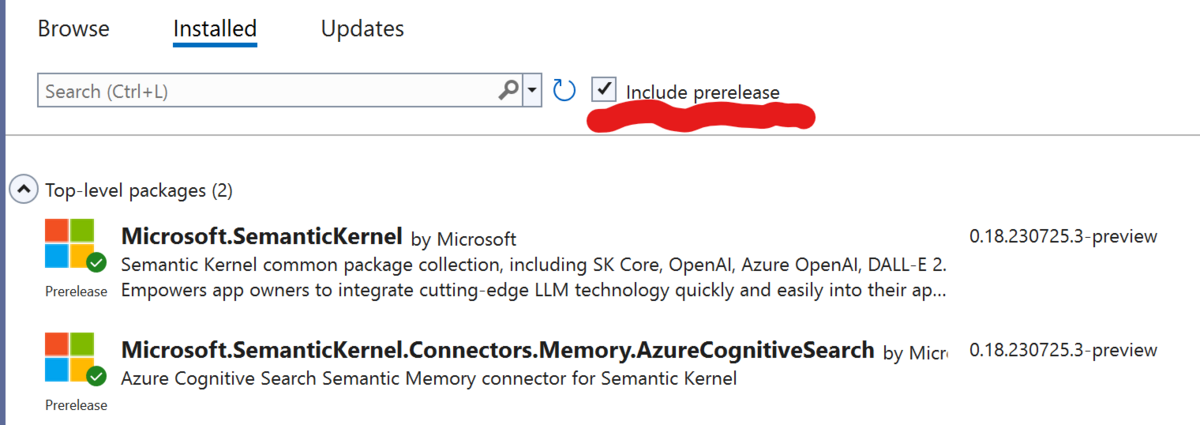

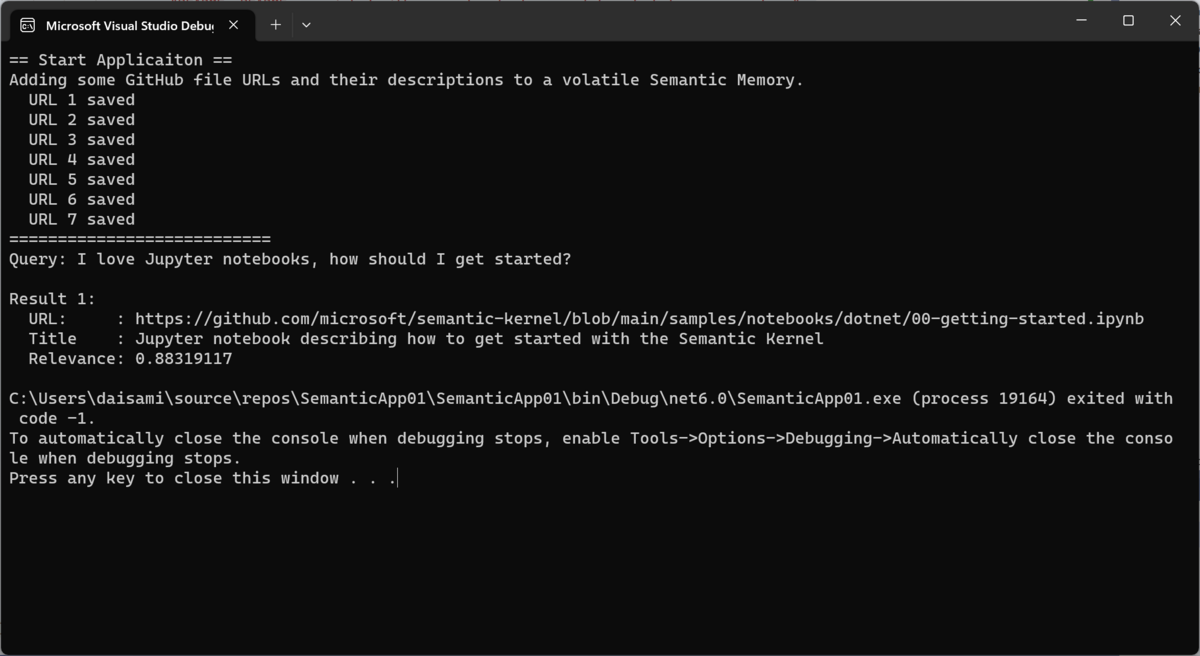

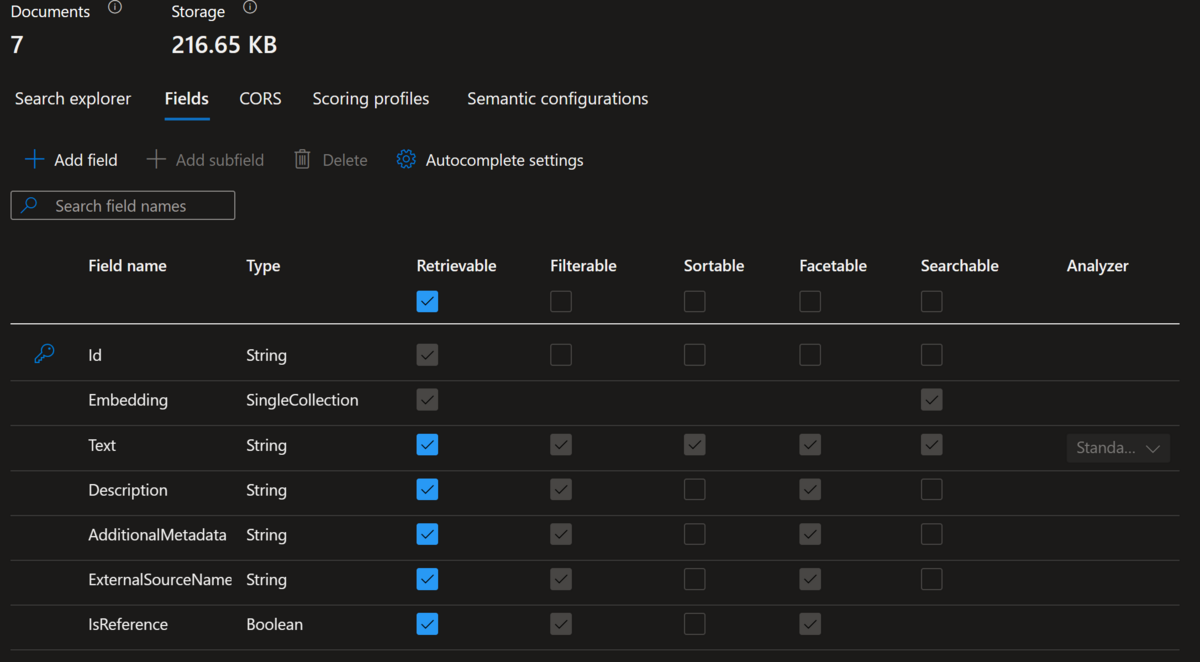

また、当然ながら自分の専門分野での英会話になるので、英会話の実践という意味でも良いなと思っています(自分の興味分野なら続きますし)。以下とかを試したのは今回の講義で出た課題の一部だったりします。

normalian.hatenablog.com

色々と書きましたが、英会話がある程度できる方が興味のある技術領域等々(分野は色々とあります)で受けてみるのは悪くないと思います。